A/B测试的ABC

我们前期所介绍的“同期群”分析法是对于时间窗口上不同时间段的特定指标比较,而今天所介绍的“A/B测试”是同一个时间窗口上不同用户群针对不同版本的反应做比较。

所谓A/B测试,是用来比较两个(或多个)版本的网页或者APP哪个“表现”更好的一种实验。A/B测试本质上是一个实验。在这个实验中,一个页面的两个或多个不同的方案显示给特定用户群(此用户分群有可能为随机,也有可能有特定特征),然后根据统计数据来分析,哪个方案在指定的“表现”上更好。我们经常会面临多个设计方案或营销策略的选择,A/B测试是解决这类问题很好的方法。

通过A/B测试,我们可以对比不同版本的用户体验区别,并针对更新版的网页或APP提问,然后收集相关数据,分析更新版网页或APP对我们既定的度量指标造成的影响。

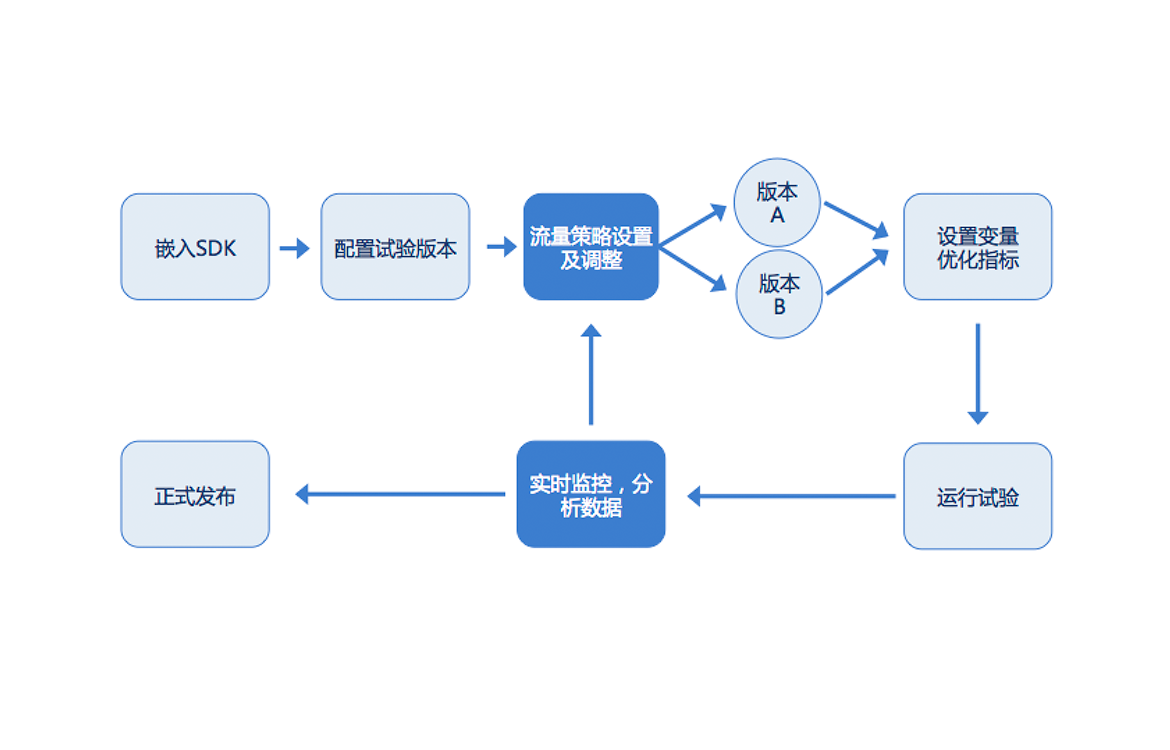

目前市面上的大部分A/B测试工具均不支持对流量进行计划分配即流量分配策略(一般为随机分配)。这样得到的测试结果,不仅不能真实的反映出目标核心用户的喜好还有可能给产品经理造成误导,对产品改进方向做出误判。在这推荐用户行为分析工具Cobub Razor,它可以帮我们准确的识别用户属性,从而为A/B测试提供流量分配策略,保证流量分配的科学性,试验结果的可信性。此外Cobub还提供了实验目标指标的实时监控及数据分析,我们可以根据分析结果实时优化调整流量策略,助力形成产品优化的闭环。

A/B测试有利于我们从界面优化中生成假设,也有利于我们依据充分的数据分析结论做出正确的决策。有A/B测试的支持,我们做决策时就可以从拍脑袋的“我认为…”转变为从数据分析结果来看“我们知道…”。通过衡量更新版对各个度量指标的影响,我们可以确保每个更新变化都产生积极的结果。

A/B测试如何运作?

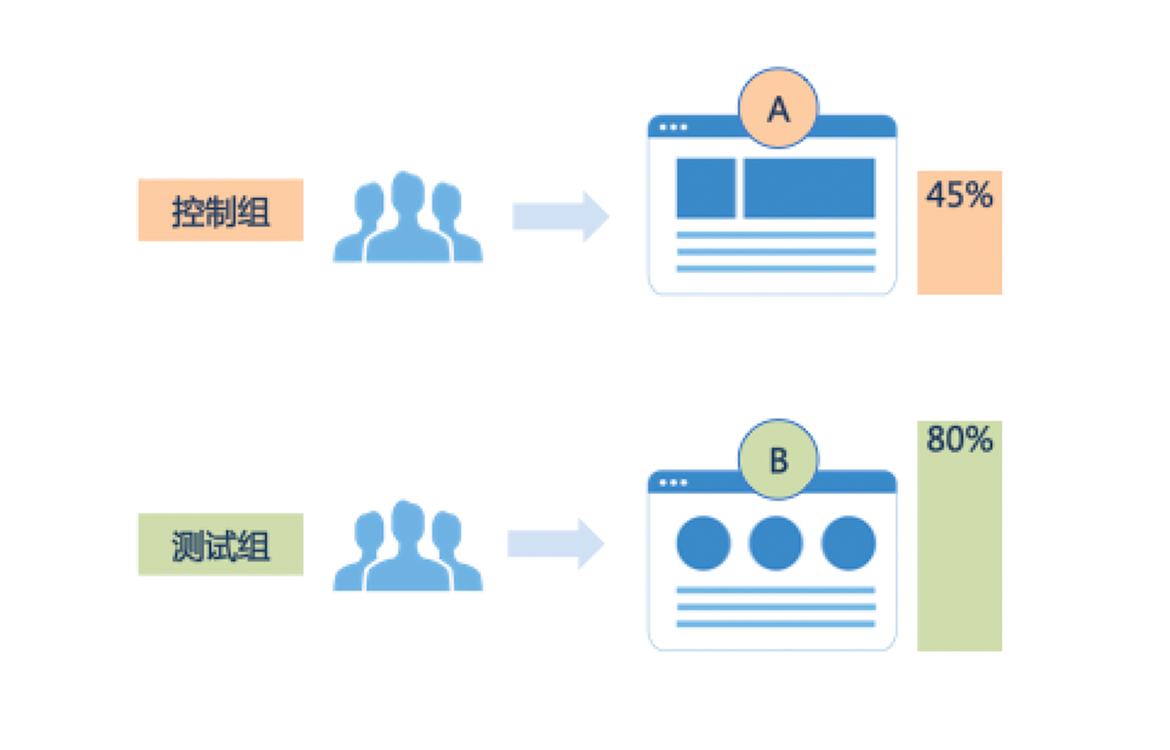

在A/B测试中,我们可以给同一个网页或APP界面创建更新版。版本之间的差异可以非常简单,如改动单个图标或按钮,也可以对页面完全重新设计。测试过程中,我们按既定策略给一半用户显示页面原始版(称之为控制组),一半显示页面的更新版(称之为测试组)。

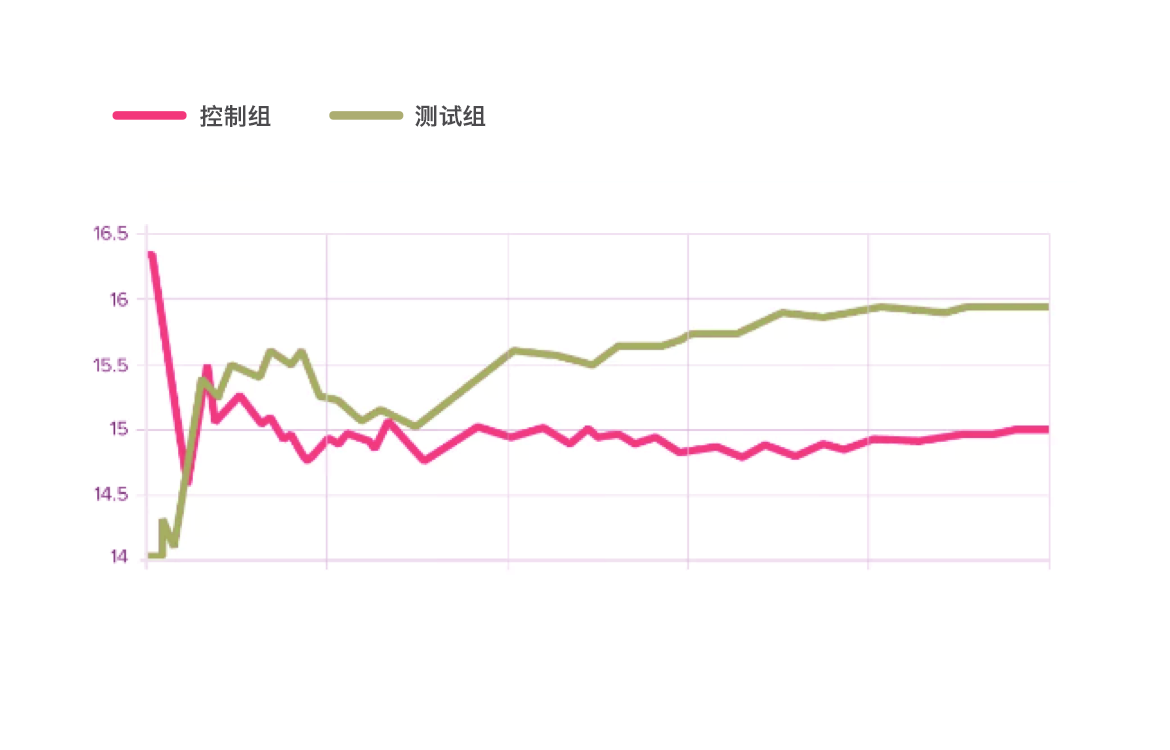

在A/B测试中,我们收集控制组和测试组的用户行为数据,然后分析更新版对用户行为造成的影响。

为什么需要A/B测试?

不管是个人,团队还是公司,做A/B测试分析数据结果之后,我们可以用数据说话,来优化产品、提升用户体验,让用户行为朝着我们期望的方向发展。A/B测试还能验证我们的假设。有时候我们从经验出发做出的产品改变并不能让得到我们预期的结果(原因是我们的客户不是让我们随意安排的)。通过A/B测试,我们可以摆脱经验主义,转向数据驱动产品发展。

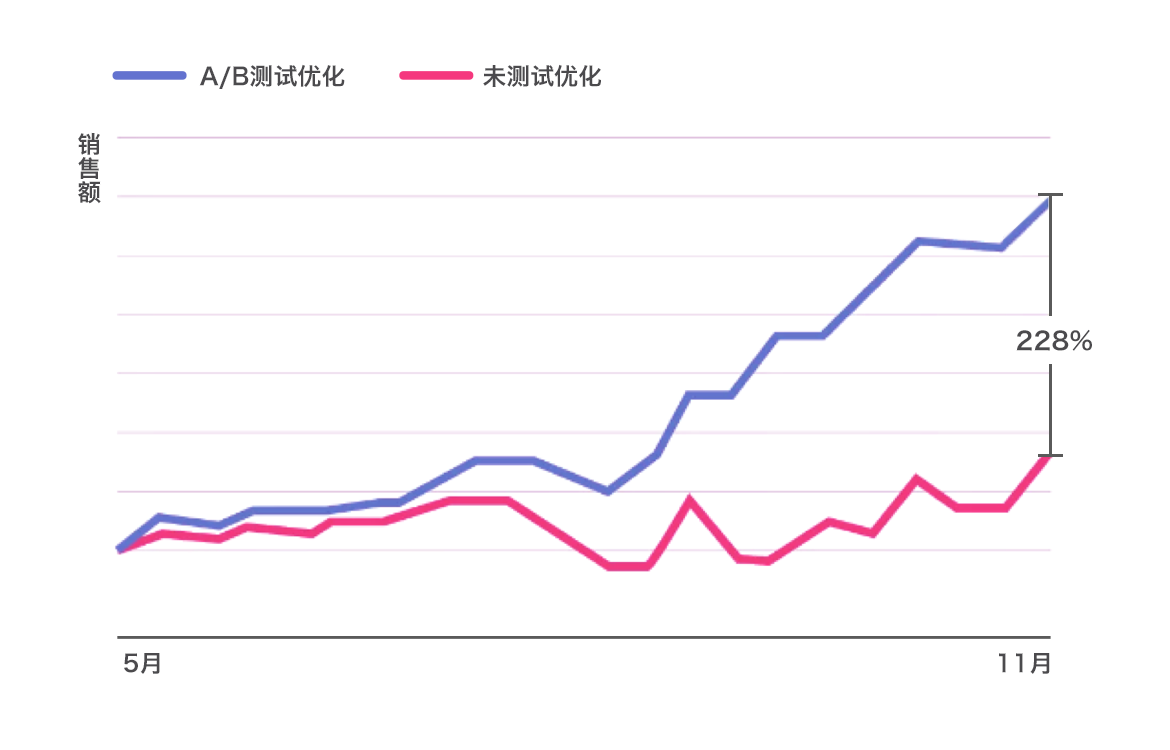

A/B测试能持续不断地让我们对产品做出改进,不断提升用户体验,从而帮助我们达到各种目标,比如注册率、转化率等。

例如,运营团队想要通过一个营销活动的着陆页来提高销售指标,为了达到这个目的,我们会尝试对标题、视觉图像、表单、行动按钮以及页面的整体布局进行A/B测试。

每次测试一个更改,可以帮助我们确定哪些更改对用户的行为产生了影响。随着时间的推移,我们的产品就会因为测试中产生的这些成功改进而变的越来越好。

A/B测试使我们能够在营销活动中针对我们想要的结果来优化产品并让用户基于我们的目标采取行动。

通过测试广告文案,我们可以了解哪个版本吸引了更多用户的点击。通过测试随后的登录页面,我们可以了解到哪种布局可以促进用户的购买。如果每个步骤的改动都能有效获得新客户,那么营销活动成本就会大大的降低。

A/B测试也可以被产品经理和设计师用来演示新特性或者改变用户体验产生的影响。产品的登录、用户参与、模式和产品体验都可以通过A/B测试进行优化。总之,我们可以通过A/B测试来实现目标,验证假设。

A/B测试过程

下面是A/B测试框架,我们可以用它来运行测试:

• 收集数据:对产品进行数据分析可以让我们发现问题从而找到需要优化的方向。首先我们需要收集数据,可以从站点或APP高流量的区域开始,这有助于我们快速发现问题的关键所在。同时我们需要寻找能够改进的低转化率和高流失率的页面。

• 确定目标:我们的转换目标是用来衡量更新版是否比原始版用户体验更好,更成功的标准。目标可以是任何东西,如点击一个按钮、链接到产品购买或者完成注册等。

• 生成假设:一旦明确了目标,我们就可以生成A/B测试的假设,这个假设用来解释为什么我们觉得更新版比原始版更好。在有了这个假设清单之后,我们可以按照预期的结果和实施难度来按顺序进行测试。

• 创建变化:有了前面几步之后,我们就可以对我们的网站或APP做出期望的改变,设计出迭代方案,这些改变可以是按钮的颜色、页面元素的顺序交换、隐藏导航或者完全重新布局的东西。我们创建的这些变化要确保它们符合我们的预期目标。

• 运行实验:启动我们的实验,等待用户参与。在这一步,我们网站或APP的用户会被随机分配到控制组和测试组,用户每一步的操作都会被纪录采集,计算和比较,以确定控制组和测试组在每一项改变上的表现。

• 分析结果:实验完成之后就是结果分析。A/B测试会显示实验数据,并告诉我们两个版本的用户行为是否存在显著差异。

• 发布最佳版本:如果测试组的行为达到了我们的预期目标,那么我们就可以继续根据A/B测试结果进一步改进产品。反之,也不必气馁,我们可以把此次测试作为经验并且生成新的假设然后继续测试。

不管测试结果如何,我们都要根据测试经验来实现产品优化的闭环并持续不断的提升用户体验。

以下是使用A/B测试过程中常产生的几个误区:

• 试验成功不等于效果提升

• 随机选取用户参与试验

• 多次试验,一点修改

• 屏蔽A/B版本的人为选择

English

English